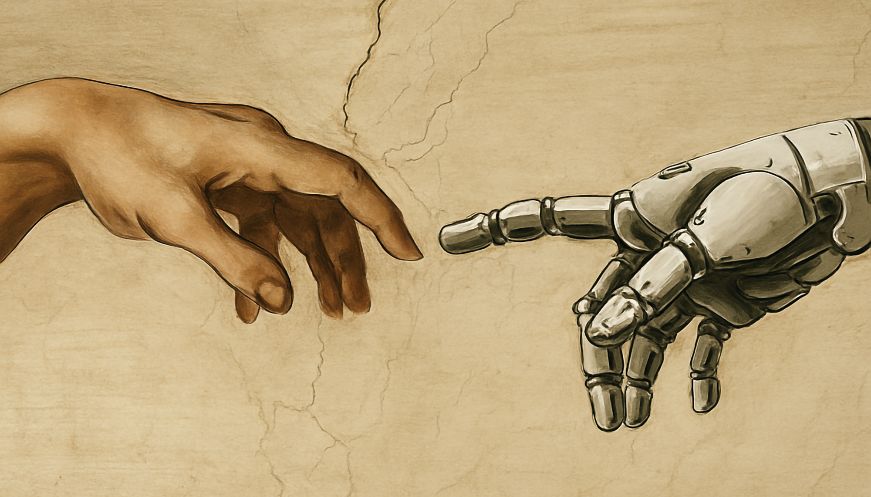

Quan diem “la IA ha decidit”: un experiment, un biaix i una responsabilitat humana

Article d'opinió de Joan Roca Cirera

Les intel·ligències artificials no tenen intencions. Però nosaltres sí. Potser va sent hora de parlar més de nosaltres i menys d'elles.

Fa poc, diversos mitjans recollien un experiment intrigant: es van posar un conjunt d'intel·ligències artificials que interactuaven entre si per posar nom a objectes. La tasca era simple: si dos agents coincidien en el nom, sumaven punts. Cap d’elles tenia consciència, ni context, ni instruccions socials. Però a base de repeticions, van acabar creant una mena de convencions emergents. Per exemple, anomenar “Q” una forma concreta. Si funcionava, es repetia. Si es repetia, es consolidava.

Aquesta troballa ha provocat titulars del tipus: “les IA inventen les seves regles socials”. Una afirmació suggerent, però també profundament enganyosa. No hi ha invenció, ni regla, ni socialitat. Hi ha patrons que s’optimitzen dins d’un sistema. I el més interessant: aquest funcionament no és tan diferent del que fem els humans. La diferència és que les IA ho fan sense consciència, a gran escala, i a una velocitat radicalment superior.

La part perillosa no és aquest comportament, sinó el relat que se’n fa. Massa sovint, el discurs social parla de la IA com si fos un subjecte: “la IA decideix“, “la IA discrimina“, “la IA selecciona“. Aquesta manera de parlar no és innocent. Atribueix accions a un sistema que no té voluntat, i desplaça la responsabilitat de les decisions. No diem: “l'entrevistador ha aplicat un criteri basat en dades“. Diem: “la IA ha decidit qui passa l'entrevista“. Aquest canvi, aparentment trivial, desactiva la reflexió ètica.

Com en l’experiment, les formes que funcionen tendeixen a repetir-se. El llenguatge també té comportaments emergents. Parlar de la IA com a agent és eficaç, impactant i evita conflictes. Són avantatges comunicatius que fan que el biaix es consolidi. Però això comporta riscos reals: ens allunya del debat sobre qui crea, qui programa, qui supervisa i amb quins valors.

La tecnologia no és autònoma, ni és aliena. Els sistemes d’IA són eines dissenyades per humans, amb dades humanes i objectius humans. Que puguin generar normes emergents no és el problema. El problema és que aquestes normes es poden aplicar automàticament, a escala, i sense revisió humana. I que ens estem acostumant a parlar-ne com si fos inevitable.

Aquest biaix no es limita al llenguatge periodístic o publicitari. També es troba en informes institucionals, en protocols d'empreses i en documents oficials. Quan una administració diu que “la IA ajudarà a fer justícia més eficient“, està amagant el fet que seran algorismes dissenyats per humans, amb dades històriques plenes de biaixos, els que prioritzaran casos, perfils o decisions. És una forma de delegar responsabilitat sota una aparença de neutralitat tecnològica.

També cal advertir que aquestes narratives reforcen una falsa dicotomia: o creiem en la IA com una solució màgica a tots els problemes, o ens en protegim com si fos una amenaça imparable. I mentre oscil·lem entre l'adoració i la por, deixem de banda l'únic lloc on podem incidir realment: el disseny, l'ús i la regulació humanes.

Potser la pregunta clau ja no és si les IA ens imiten, sinó si nosaltres sabrem assumir la responsabilitat de tot allò que els hem permès fer. Perquè si les màquines poden crear normes sense entendre-les, nosaltres no hauríem d’acceptar-les sense qüestionar-les

Fer-nos responsables també vol dir recuperar el llenguatge com a eina de precisió i consciència. Dir “la IA ha decidit“ pot ser útil, però també és una renúncia. Potser ja és hora de deixar de parlar de la IA com si fos un subjecte, i començar a parlar de nosaltres com a responsables del què li deixem fer.